谷歌提出新架构,突破Transformer超长上下文瓶颈

文章导读

还在为模型记不住超长文档而苦恼吗?谷歌最新研究为你带来“测试时训练”这一颠覆性思路。他们刚刚发布的两大新架构——Titans与MIRAS,能让模型在推理阶段像人脑一样持续学习,将上下文窗口一举扩展至惊人的200万token,性能甚至超越了规模更大的GPT-4。本文将为你揭秘这种突破Transformer瓶颈的核心机制,以及它如何重塑我们对大模型能力的认知。

— 内容由好学术AI分析文章内容生成,仅供参考。

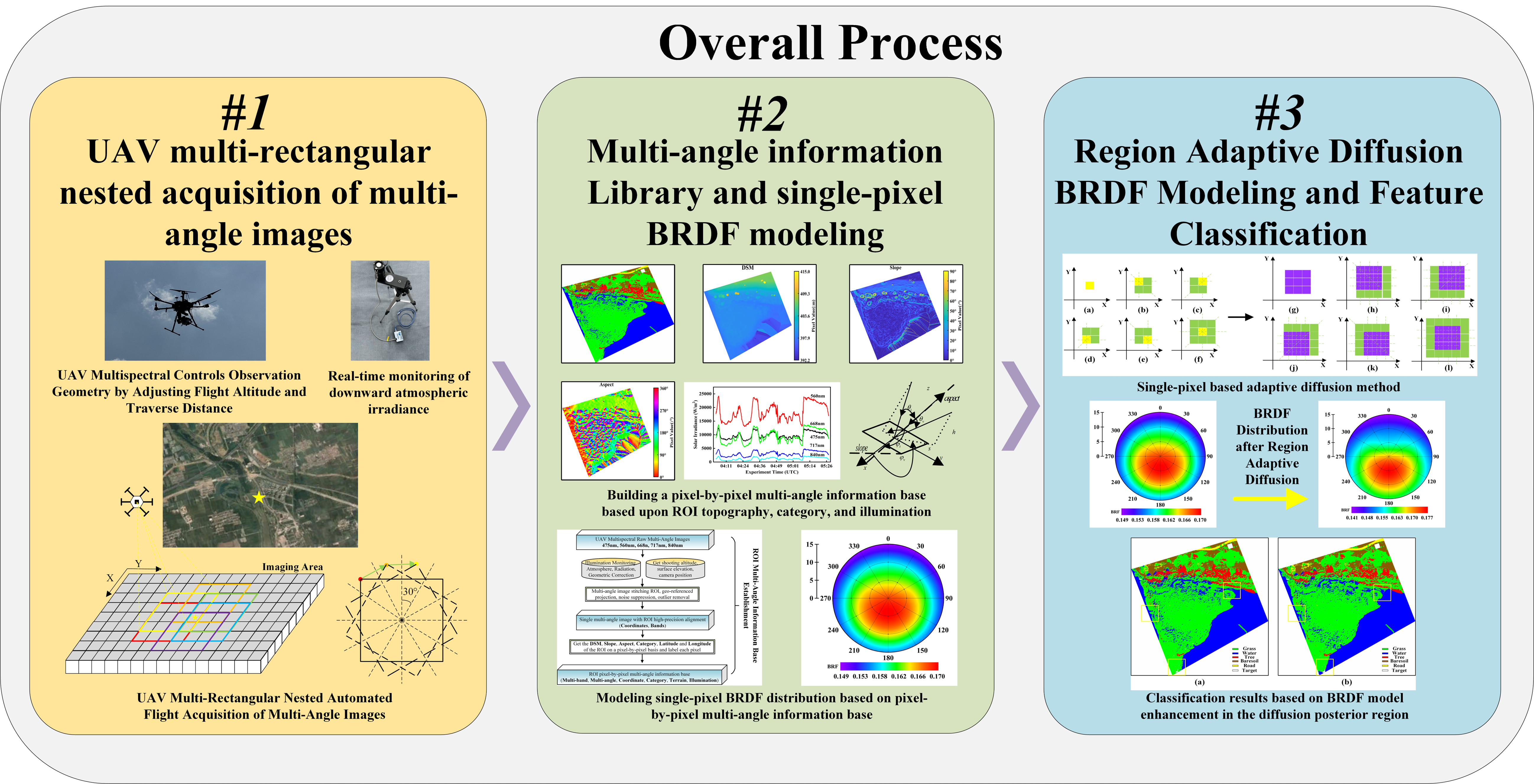

在2025年神经信息处理系统大会(NeurIPS 2025)上,谷歌发布两项大模型新架构Titans和MIRAS,通过“测试时训练”机制,能在推理阶段将上下文窗口扩展至200万token。其中,Titans引入了一种新的神经长期记忆模块,相较传统循环神经网络(RNN)中固定大小的向量或矩阵记忆,该模块本质上是一个在测试时动态更新权重的多层感知机,在推理阶段仍可持续更新记忆模块。该模块能显著提升模型的表达能力,使其在不丢失重要上下文的情况下概括并理解大量信息。MIRAS核心目标是让模型在推理阶段也能进行学习,通过将不同的架构视为解决同一问题的不同途径,高效地将新信息与旧信息相结合,同时又不遗漏关键概念。同时,引入非欧几里得目标函数,允许使用更复杂的数学惩罚机制。实验结果显示,基于Titans和MIRAS的模型性能优于最先进的线性循环模型(如Mamba 2),以及规模相近的Transformer基线模型。同时,新架构能够处理极长上下文,在参数规模小得多的情况下,性能优于GPT-4等大规模模型。

© 版权声明

本文由分享者转载或发布,内容仅供学习和交流,版权归原文作者所有。如有侵权,请留言联系更正或删除。

这宣传标题党,实际能省多少还未知 🤔

其实类似的动态记忆思路在2023年已有小规模实验,只是当时算力不足。

看起来谷歌又要把竞争对手逼到墙角,MIRAS的自学习听起来有点科幻。

我之前实验时也卡在上下文限制,真是头疼。

Titans的长期记忆模块在实际部署时会不会导致显存飙升?

这玩意儿真是牛逼,直接省了好多算力。