阻变存储器存算一体芯片研究取得进展

文章导读

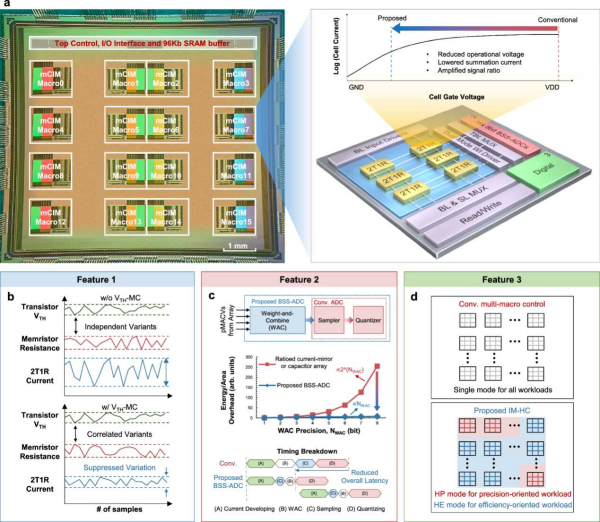

你是否想过,AI芯片的能效极限还能被突破?中国科学院微电子所窦春萌团队最新成果揭晓:一款基于阻变存储器(RRAM)的存算一体芯片,创新性采用近阈值计算,成功攻克工艺波动难题。通过2T1R单元设计、电荷域计算与混合精度控制,实现高达88.51 TOPS/W的能效和2.4%的低计算误差。这项发表于《自然-通讯》的研究,或将重塑边缘AI硬件的未来格局。

— 内容由好学术AI分析文章内容生成,仅供参考。

边缘端人工智能(AI)硬件凭借其低延迟、高能效和强隐私性等优势,得到广泛关注与应用。在功耗严格受限的边缘端部署AI硬件,不仅需要高能效以满足功耗约束,还需要高并行度以提升实时性能。基于阻变存储器(RRAM)的存算一体和近阈值计算作为两种高效能计算范式,有望在实现高能效、高并行的AI硬件中发挥关键作用。然而,受工艺波动的影响,这两种计算范式的规模与可扩展性仍面临挑战。此外,如何有效结合这两种范式以开发低功耗、高并行的AI硬件,目前仍缺乏深入研究。

针对上述问题,中国科学院微电子研究所研究员窦春萌团队设计并实现了一款基于近阈值计算的RRAM存算一体芯片。研究人员利用双晶体管单阻变存储器(2T1R)单元,将RRAM的阻变特性转化为阈值电压调控特性,提出RRAM-CMOS阈值电压失配抵消技术,有效抑制了长期困扰两种计算范式的工艺波动问题。针对网络模型多比特乘累加运算的需求,团队提出了基于电荷堆叠的新型电荷域计算技术,实现了一种采样、加权与量化一体化模数转换电路,显著降低了外围电路的功耗与面积开销。团队在多核存算一体系统中引入了核间混合精度控制技术,通过对神经网络各层数据特征进行分析,为每个计算核心配置优化的累加与量化方法,实现了任务级推理功耗的高效优化。

基于上述设计,团队成功流片验证了具有16个计算核心的近阈值RRAM存算一体芯片。该芯片可实现256通道累加的高并行模拟计算,平均相对标准差低至2.4%,计算能效可达55.21至88.51 TOPS/W。该研究展示了高能效、高并行近阈值RRAM存算一体技术,为边缘AI硬件的发展提供了新思路。

近期,相关研究成果以A near-threshold memristive computing-in-memory engine for edge intelligence为题,发表在《自然-通讯》(Nature Communications)上。

(a)芯片显微照片、关键结构和近阈值计算方案;(b)RRAM-CMOS阈值电压失配抵消技术;(c)采样、加权与量化一体化模数转换技术;(d)核间混合精度控制技术

© 版权声明

本文由分享者转载或发布,内容仅供学习和交流,版权归原文作者所有。如有侵权,请留言联系更正或删除。

相关文章

暂无评论...