研究开发出新型AI医疗诊断系统

文章导读

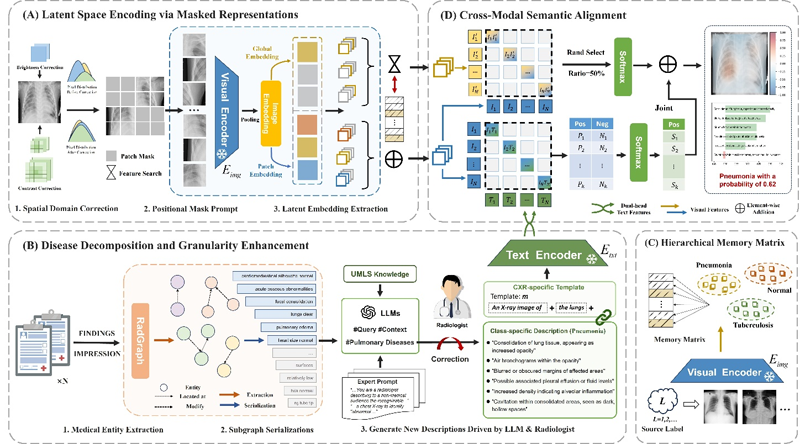

当医生面对胸片中的陌生疾病束手无策时,这台AI竟能瞬间看穿病灶本质!中科院突破性研发Multi,首次实现"零样本"胸片智能诊断——无需任何标注数据,即可精准识别连传统AI都束手无策的新发疾病。该系统通过独创的双流协同架构:图像分支自动定位病灶并理解解剖结构,文本分支融合大语言模型与专家知识生成精准病理描述。跨模态深度技术让机器真正"读懂"胸片,在零样本场景下诊断性能超越主流模型3.9%,关键指标AUC提升达7.5%,其诊断逻辑已无限接近人类医生级思维。这场医学AI的认知革命,正将我们推向自主理解疾病的新

— 内容由好学术AI分析文章内容生成,仅供参考。

近日,中国科学院合肥物质科学研究院研究团队开发出新型AI医疗诊断系统MultiXpert。该系统能够在“零样本”条件下对胸片进行智能诊断,无需任何标注数据,甚至可识别出从未见过的疾病,使AI具备更接近医生诊断思维的能力。

胸片是临床常用的影像学检查手段之一,但人工判读耗时且依赖专家经验。传统AI系统在一些任务上能够媲美专家,却依赖大量人工标注数据,难以应对新发疾病或不同医院之间的数据差异,导致模型泛化能力有限,无法满足复杂临床环境下精准诊断的需求。

研究团队提出了多模态双流协同增强的新思路,构建了无需额外标注数据即可实现零样本高精度诊断的胸片智能分析系统。该系统能够同时处理图像与文字信息,并利用大语言模型和放射科专家知识优化病灶描述,实现图像与语言的深度融合。这一成果让AI在未见疾病中也能“看懂”胸片,其思考逻辑更趋近于专业医生的水平。

在图像分支中,通过引入病灶感知掩码机制,MultiXpert能够在无显式标注情况下提升对潜在病灶的特征表达能力;通过分层记忆矩阵实现全局解剖信息与局部病灶特征的动态平衡,提升模型对复杂影像的结构化理解能力。在文本分支中,联合大语言模型与临床专家知识,MultiXpert能够对疾病描述进行语义校准与结构化重构,生成同时具备解剖精准性与临床标准化的病理描述文本,增强医学语义的表达一致性。通过跨模态语义对齐模块实现多粒度信息的互补融合,提升了模型在零样本条件下的病灶识别与诊断性能。实验结果显示,MultiXpert在四个单标签公共数据集上平均AUC提升达7.5%,在零样本场景下较主流视觉语言模型平均提升3.9%。

这一研究为胸片零样本智能诊断提供了新的技术路径,为医学AI从“依赖标注”迈向“自主理解”提供了新范式。

相关研究成果发表在Information Processing and Management上。研究工作得到国家自然科学基金等的支持。

多模态双流协同增强模型MultiXpert结构示意图

© 版权声明

本文由分享者转载或发布,内容仅供学习和交流,版权归原文作者所有。如有侵权,请留言联系更正或删除。

相关文章

暂无评论...