非GPT架构首次显著超越Transformer

文章导读

主导AI领域的霸主级模型迎来强敌?MIT前团队打造的非Transformer新架构LFM,以1.3B到40.3B的灵活体量,在基准测试中实现了更优性能与5倍内存缩减的双赢突破。这个全新开源系列模型不仅解决了传统架构在处理超长序列数据时的"记忆过热"难题,更通过混合计算单元打破视频/音频/文本的模态壁垒。当液体基础模型在边缘设备上跑出超越GPT系列的表现时,AI界对Transformer的十年封印正在被悄然瓦解,工业4.0、智慧城市等对实时性要求严苛的领域或将迎来颠覆性变革。

— 内容由好学术AI分析文章内容生成,仅供参考。

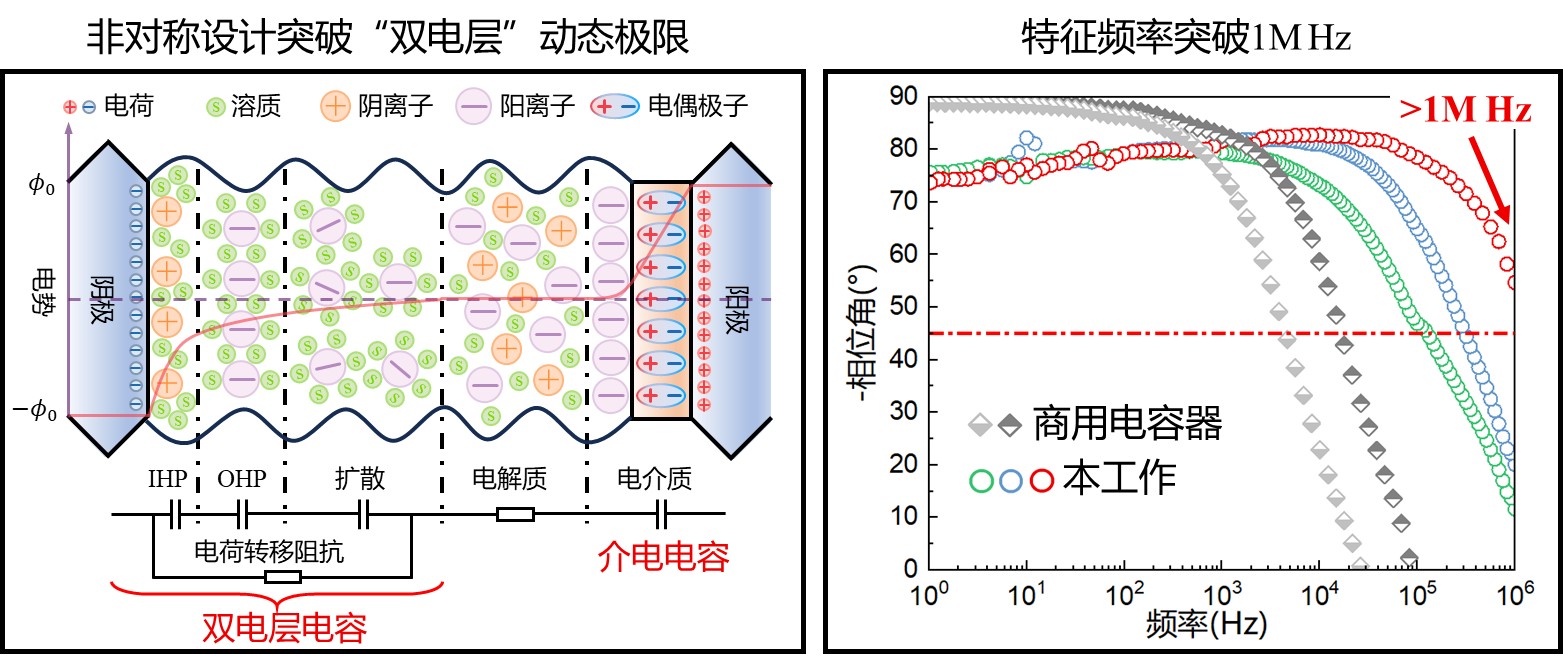

10月1日,MIT计算机科学与人工智能实验室(CSAIL)的前研究人员创立的初创公司Liquid AI推出了名为液体基础模型(LFM)的多模态非Transformer模型。该模型在基准测试中超越了传统Transformer模型,实现当前最佳性能,同时保持更小的内存占用和更高效的推理。LFM系列包括1.3B、3B和40.3B三种尺寸的模型,适用于资源受限环境、边缘部署优化和处理复杂任务。与传统的Transformer模型相比,LFM在长输入处理上内存效率更高,能够处理更长的序列。LFM-1B模型在基准测试中表现优异,成为非GPT架构首次显著超越Transformer模型的案例。Liquid AI的模型利用了混合计算单元,可模拟任何类型的序列数据,包括视频、音频、文本等,旨在解决多个行业的特定挑战。

© 版权声明

本文由分享者转载或发布,内容仅供学习和交流,版权归原文作者所有。如有侵权,请留言联系更正或删除。

相关文章

暂无评论...