让虚拟智能体听懂自然语言并执行多样物理动作,一直是AI界的圣杯任务。传统强化学习依赖人工奖励设计,模仿学习又受限于数据分布,想要扩展到开放词汇的复杂任务,常常步履维艰。

北京大学人工智能研究院朱毅鑫课题组及合作者的成果以“GROVE: A Generalized Reward for Learning Open-Vocabulary Physical Skill”为题,被人工智能顶级会议CVPR 2025接收为Oral Presentation(Top 3.3%)。

该论文提出了一种奖励自改进机制:通过融合大型语言模型(LLM)和视觉语言模型(VLM)的互补优势,实现了无需手工设定奖励函数也能学会“听指令、动得准”的通用物理技能学习框架。LLM提供精准物理约束,VLM则评估动作的语义自然性,二者相辅相成,构建出一个动态优化、逐步自我完善的奖励系统,让AI学技能不再“靠死记硬背”,而是“边学边改”。

论文截图

为解决VLM生成的奖励函数受光照遮挡影响严重的问题,研究团队开发了轻量级映射模型Pose2CLIP,可直接将智能体姿态映射到图像特征空间,避免高成本渲染,提升训练效率。同时也产出了超过170万帧的“智能体姿态-图片特征”配对数据集,后续将逐步开源。

图1 基于GROVE生成的物理合理动作(部分)

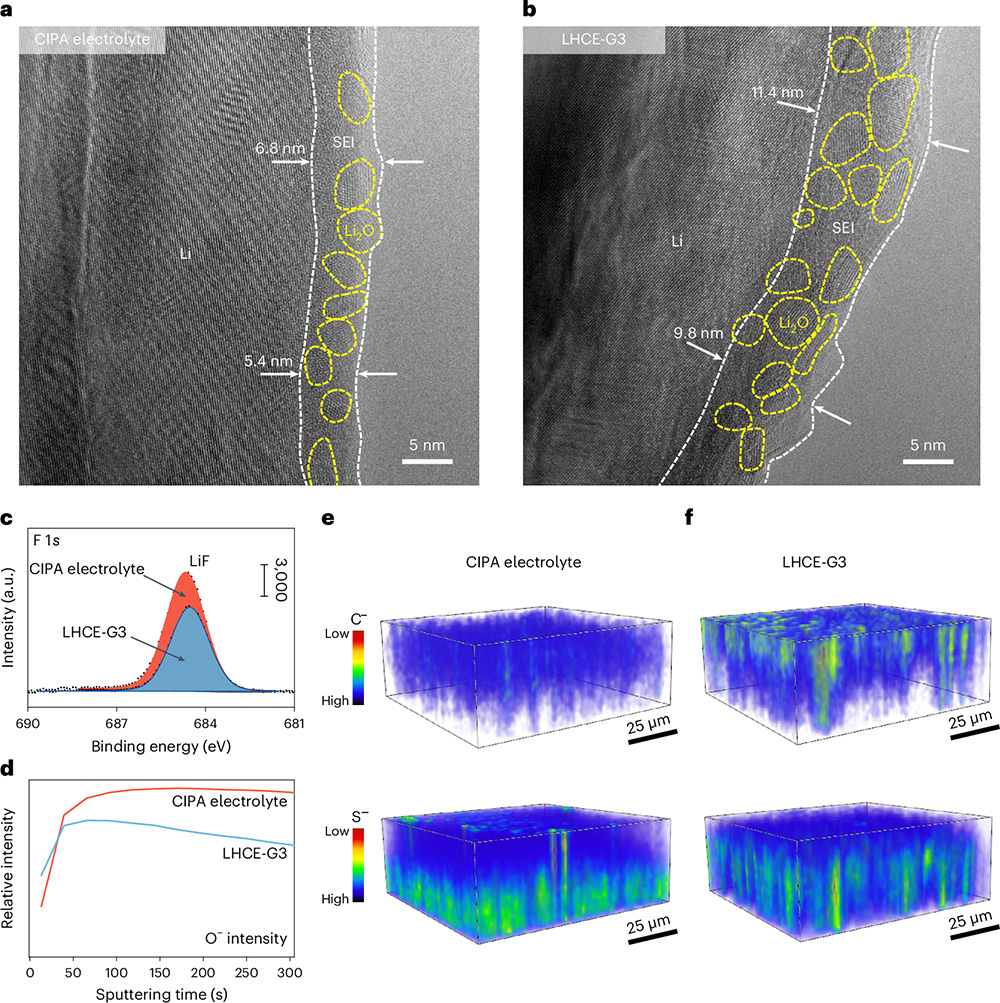

在人工智能领域,如何让虚拟角色通过自然语言指令学习多样化的物理技能一直是一个重要挑战。传统的强化学习方法依赖于人工设计的奖励函数,例如训练一个人形机器人“向前跑”需要手动设置速度、能量消耗等多重奖励条件。这种方式不仅耗时,而且难以推广到开放词汇的新任务中。

近年来,模仿学习和大语言模型(LLMs)等技术的出现为这一问题提供了部分解决方案,但它们各自存在局限性:模仿学习需要大量特定任务的演示数据,而LLMs虽然能生成精确的物理约束,却无法评估动作的整体自然性和语义合理性。例如,LLMs可能生成技术上正确但看起来不自然的动作,而视觉语言模型(VLMs)虽然能判断动作是否“看起来正确”,却难以保持时间一致性或精确的物理约束。因此,如何结合两者的优势,开发一种既能理解开放词汇指令又能生成自然动作的通用奖励框架,成为了当前研究的核心问题。

图2 传统RL算法的待解决问题

图3 本文提出的GROVE模型框架

针对上述挑战,本文提出了GROVE,一种无需人工设计奖励或任务特定演示的通用奖励框架,旨在通过结合大型语言模型(LLM)对细化到关节的准确控制以及视觉语言模型(VLM)提供的丰富语义信息,实现开放词汇物理技能的学习。核心思想在于:更有效的VLM信息提供方式;VLM与LLM之间的迭代式奖励优化;能够在多种智能体上体现有效性。

GROVE为了避免仿真环境图像与VLM训练数据之间的领域差异,团队开发了Pose2CLIP这一轻量级映射模型,能够直接将智能体的姿态信息转化为CLIP特征空间中的语义表示,省去了耗时的渲染过程。Pose2CLIP模型的训练采用了170万帧高质量渲染的人体姿态数据,这些数据来自开源数据集(AMASS、Motion-X)以及训练过程中产生的失败和成功的样本。为了确保模型的鲁棒性,每个姿态都从5个不同视角(前、侧、斜、后侧和后)进行渲染,并通过Blender增加更丰富的texture。模型针对人体动作的长尾性采取了基于k-means++聚类的分层均匀采样策略,有效解决了训练数据分布不平衡的问题。

图4 渲染前后的图片对比

在分别获得LLM与VLM有效信息之后,GROVE将物理技能学习建模为奖励设计问题(RDP),其核心是通过迭代式奖励优化实现指令与动作的精准对齐。具体而言,RDP被形式化为三元组P=ξ,R,F,其中R代表所有可能奖励函数构成的函数空间,F为适应度函数,其将策略π映射为一个实值适应度评分F(π)。世界模型ξ=S,A,T完整刻画了环境动力学特性,其中S为状态空间,A为动作空间,T则是支配环境状态转移的动态函数。文章将VLM的输出值作为适应度评分的标准,当连续8个训练步骤中VLM奖励的平均值出现下降且最终值低于阈值k时,系统会自动触发LLM奖励函数的重新生成,从而进行及时的学习目标纠正。

图5 GROVE奖励函数生成流程

文章为了证明GROVE的综合能力,首先在多种智能体上进行从零开始(from scratch)的试验测试,这些智能体包含从简单智能体蚂蚁(Ant)到复杂智能体类人(Humanoid)的多种类别,以及近段策略优化(PPO)和柔性动作-评价(SAC)两种不同的基线方法。

图6 GROVE在不同智能体上的实验结果

图7 GROVE与仅用VLM作为奖励函数的基线方法进行比较

图8 从零开始的部分实验展示

之后为了证明GROVE的泛用性,GROVE基于在少量人体数据集上预训练好的低阶控制器又进行了试验测试,包括与现阶段各个类别的SOTA方法进行比较、进行模型所有组成部分的消融实验。

图9 GROVE与现阶段各类SOTA方法进行比较

图10 GROVE的消融实验

图11 输入命令为Position body in a shape of ‘C’ 的生成动作

图12 输入命令为Walk like a model的生成动作

图13 输入命令为Playing the suona的生成动作

在不同智能体形态和学习范式下的广泛实验显示GROVE框架具有卓越性能:动作自然度提升22.2%,任务完成度提高25.7%,同时训练速度达到传统方法的8.4倍。这一突破为模拟环境中可扩展的物理技能学习奠定了新的技术基础。

论文的第一作者为北京大学博士生崔洁茗和北京通用人工智能研究院刘腾宇研究员,其他作者为山东大学博士生孟子喻、清华大学本科生於家乐、山东大学张伟教授和山东大学宋然教授,通讯作者为北京大学朱毅鑫助理教授和北京通用人工智能研究院黄思远研究员。

© 版权声明

本文由分享者转载或发布,内容仅供学习和交流,版权归原文作者所有。如有侵权,请留言联系更正或删除。

相关文章

暂无评论...