美利用反向传播大语言模型反馈来优化生成式人工智能系统

文章导读

还在为生成式AI系统优化依赖人工调参而头疼?斯坦福团队重磅突破:TextGrad框架首次实现用大语言模型(LLM)反馈反向传播优化AI系统!它通过“文本梯度”让组件以自然语言自动迭代,无需触碰底层参数,兼容黑箱API。实测惊人:LeetCode代码完成率从26%跃升至36%,科学问答准确率飙升,前列腺癌放疗计划甚至超越临床经验。这一开源工具不仅能加速科学发现、提升工程效率,更让AI参与自身优化,直击“幻觉”痛点——阅读全文,解锁AI自我进化的未来钥匙!

— 内容由好学术AI分析文章内容生成,仅供参考。

3月19日,据Nature期刊网站消息,美国斯坦福大学的研究人员开发出TextGrad框架,通过反向传播大语言模型(LLM)生成的反馈来优化生成式人工智能(AI)系统。相关研究成果以“Optimizing generative AI by backpropagating language model feedback”为题发表于《Nature》期刊上。

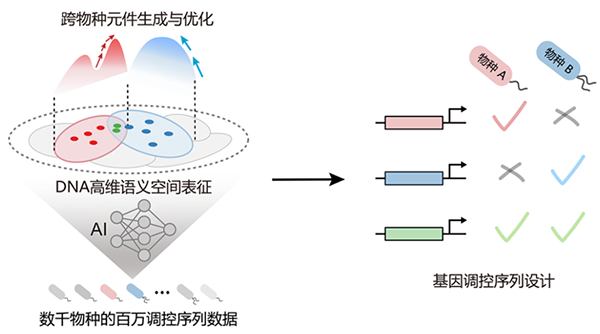

近年来,生成式AI取得了诸多突破,其应用于具体领域时通常需要协同多个LLM和其他专业工具组件,形成复合AI系统。目前,这类系统大多由领域专家手工构建,并通过启发式方法进行调整,缺乏自动化的优化方法。此前,神经网络的发展也面临类似困境,而反向传播和自动微分技术的运用,助力神经网络实现了自动优化。受此启发,研究人员开发出TextGrad框架,旨在解决复合AI系统的优化难题。TextGrad把每个复合AI系统转化为计算图,其中的不同组件通过复杂函数交换非结构化数据,以自然语言为媒介实现“文本梯度”传递,通过反向传播LLM生成的反馈来执行优化,以改进复合AI系统。此外,反馈不针对神经网络底层参数,能够与黑箱API(应用程序编程接口)兼容,最终实现了基于文本的自动微分优化。研究人员在多个领域验证了TextGrad的通用性和优化效果:在编写代码方面,研究人员利用LeetCode Hard数据集展开测试,TextGrad在零样本设置下将gpt-4o代码完成率从26%提高到36%,超越了其他基线方法;在回答科学问题方面,研究人员利用多个问答数据集进行测试,TextGrad显著提升了gpt-4o在这些基准测试中的回答准确率;在给出提示方面,TextGrad借助更强的模型(如gpt-4o)为较弱模型(如gpt-3.5-turbo)提供反馈,在多个推理任务数据集上优化了提示,使得模型性能得到提升;在制定治疗计划方面,TextGrad针对前列腺癌患者的放疗计划进行优化,在提高肿瘤靶区剂量、保护健康器官等方面表现优于人工临床经验和贝叶斯优化算法。此外,TextGrad还能够优化涉及多个变量和长推理链的复合AI系统,进一步提升其性能。

这项研究提出的TextGrad开源框架具有通用性和易用性,为生成式AI系统的优化提供了新工具,在多个领域展现出优异效果,有望加速科学发现进程,提高工程设计效率。此外,TextGrad能够使LLM参与到修正自身的迭代优化中,这种“语言驱动的优化”展现出克服“AI幻觉”的潜力。

© 版权声明

本文由分享者转载或发布,内容仅供学习和交流,版权归原文作者所有。如有侵权,请留言联系更正或删除。

相关文章

暂无评论...