文章导读

当传统相机在暗夜或高速运动中“失明”,如何让机器依然看清世界的动态?华中科技大学颜露新团队首创将事件相机与帧相机互补融合,注入扩散模型生成运动场,突破性实现极端场景下的高精度光流估计。这项发表于NeurIPS的亮点成果,不仅刷新低光、高速环境下的性能纪录,更将赋能自动驾驶、精密制造与神经科学,让机器感知迈向类脑新境界。

— 内容由好学术AI分析文章内容生成,仅供参考。

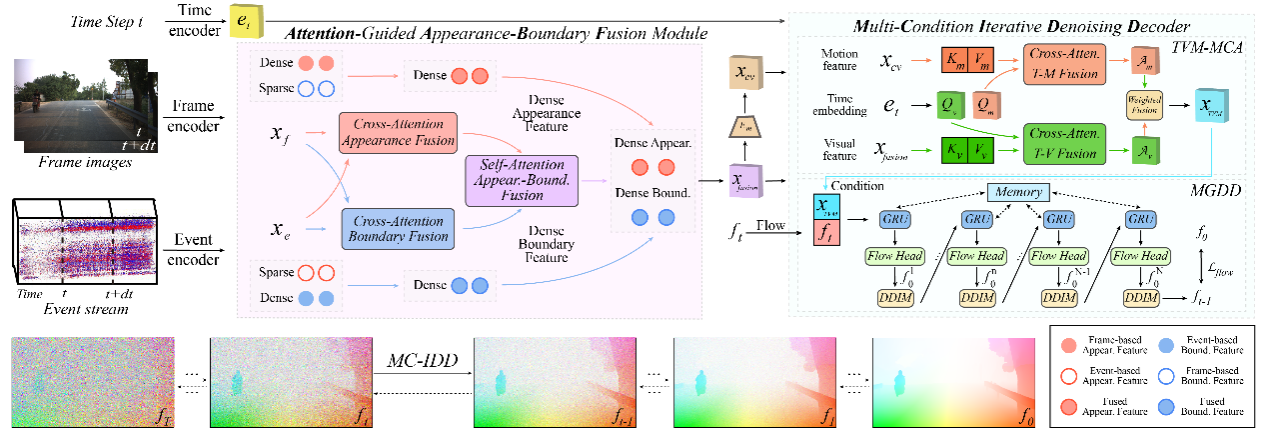

近日,我校人工智能与自动化学院、多谱信息智能处理技术全国重点实验室颜露新教授团队在生成范式神经形态视觉运动感知方面的工作“Injecting Frame-Event Complementary Fusion into Diffusion for Optical Flow in Challenging Scenes”,被人工智能领域顶级会议The Thirty-Ninth AnnualConference on Neural Information Processing Systems(NeurIPS)接收为亮点(spotlight)论文。该研究探索了神经形态视觉传感器与帧相机之间的互补机制,提出了生成式模型的跨模态融合运动估计方法,其性能在低光、高速等挑战性场景领先。

以事件相机为代表的神经形态视觉传感器具有宽动态范围和高时间分辨率的优势,在低光、高速等极端场景表现出优越的成像性能;扩散模型在退化场景的图像生成领域应用广泛,而在下游视觉任务尚缺探索。研究团队围绕极端退化场景运动估计任务,研究了事件相机与帧相机之间的表观-边缘互补性,构建了以互补融合特征为条件的扩散模型,迭代生成退化场景的高质量运动场。

图为基于扩散模型的跨模态融合生成运动估计。

该研究成果具备广阔应用前景。在自动驾驶、工业检测和机器人等应用场景,该技术可在夜间、高速环境下实现稳健的运动感知与微秒级实时监测,支撑动态目标检测、高速避障和精密制造中的质量控制;在生命科学与医学成像领域,它有望辅助神经活动追踪和显微尺度的快速运动观测,为神经科学研究与医疗诊断提供新工具。

我校人工智能与自动化学院2025级直博生王浩楠为论文第一作者,博士毕业生周寒宇(现在新加坡国立大学从事博士后研究)和博士生刘昊岳深度参与相关工作。论文工作得到国家自然科学基金联合基金重点项目(U24B20139)资助。

© 版权声明

本文由分享者转载或发布,内容仅供学习和交流,版权归原文作者所有。如有侵权,请留言联系更正或删除。

相关文章

暂无评论...